Библиотека

Теология

КонфессииИностранные языкиДругие проекты |

Ваш комментарий о книге Величковский Б. Когнитивная наука: Основы психологии познанияОГЛАВЛЕНИЕГЛАВА 2. ТРАНСФОРМАЦИЯ ПОДХОДОВ2.1 Информационный подход

2.2 Компьютерная метафора

2.3 Модулярность познания и коннекционизм

2.4 Усиливающееся влияние нейронаук

92 На рубеже 1960-х годов произошла быстрая смена сферы интересов и теоретической ориентации мировой экспериментальной психологии. Термин «когнитивный» стал относиться не только к высшим познавательным процессам, но также к восприятию и даже моторике, мотивации и эмоциям. Складывается впечатление, что иногда он используется, по словам голландского психолингвиста Флореса д'Аркэ, «в качестве модной этикетки, позволяющей сбыть залежалый товар» (Flores d'Arcais, 1975, p. 45). Отдельным примерам такого рода, несомненно, противостоит — особенно в лице междисциплинарной когнитивной науки — ведущее направление современных научных исследований поведения и психики человека. Это направление постоянно развивается и имеет значительное число способных и активных сторонников. 2.1 Информационный подход

|

|||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|

Количество информации измеряется, таким образом, в двоичных логарифмических единицах, или битах. Передача количества информации, равного одному биту, позволяет уменьшить неопределенность ситуации вдвое, двух битов — вчетверо и т.д. Множество всех возможных событий, естественно, заранее должно быть известно на принимающей стороне. Приведенная выше формула описывет максимально возможное количество информации, достигаемое в случае, когда система событий совершенно случайна. Если система событий структурирована, так что разные события возникают с различной вероятностью/>, то среднее количество информации для множества из N событий определяется несколько более сложной формулой:

|

Именно эта информация Я при продолжительном предъявлении сигналов определяет нагрузку на канал связи. Разница между максимально

95

96

возможным и фактическим количеством информации определяет далее так называемую избыточность системы событий. Избыточность является ничем иным, как мерой организации такой системы, степени ее отличия от совершенно случайного, хаотичного состояния. Важным источником избыточности в канале связи являются, наряду с абсолютной вероятностью возникновения событий, условные вероятности следования события друг за другом. Так, поскольку появление, а главное, следование отдельных фонем друг за другом в звуках человеческой речи далеко не равновероятны, общая избыточность системы фонем (или же букв при письме и чтении) естественных языков оказывается довольно большой, примерно равной 70%.

С инженерной точки зрения, можно говорить далее о различной степени оптимальности процессов кодирования информации. Оптимальным является такое кодирование событий, например в виде последовательностей двоичных символов «0» и «1», при котором более вероятные события будут представлены, более короткими цепочками символов. Интересно, что соответствующая эмпирическая зависимость — чем частотнее слово в языке, тем оно короче — действительно известна в лингвистике, где она называется «вторым законом Ципфа». При оптимальном кодировании канал связи, имеющий пропускную способность С бит/с, будет передавать С/Н двоичных символов в секунду. Если кодирование не оптимально, то фактическая скорость передачи информации уменьшится. Она в принципе никогда не может превзойти пропускную способность канала С, а тем более стать бесконечной (Яглом, Яглом, 1973).

Первой претеоретической метафорой будущей когнитивной психологии стало, таким образом, понимание человека как канала связи с ограниченной пропускной способностью. Это понимание буквально совпадало с тем специфическим аспектом рассмотрения возможностей человека, который был характерен для проводившихся еще в годы Второй мировой войны инженерно-психологических исследований. Поскольку экстремальные условия войны и начавшегося сразу после нее военно-индустриального соревнования Востока и Запада вновь и вновь обнаруживали специфические слабости человеческого звена в системе человек—машина, необходим был единый язык описания ограничений как техники, так и самого человека-оператора. Теория информации была воспринята многими психологами и инженерами как своего рода лапласовская «мировая формула» (см. 1.1.2), позволяющая единообразно описать возможности не только технических звеньев человеко-машинных систем, но и большое количество собственно психологических феноменов.

В силу их значительного и продолжающегося влияния на когнитивный подход, нам следует хотя бы кратко остановиться здесь на особенностях и эволюции исследований «человеческого фактора» {humanfactorengineering), получивших в Западной Европе и СССР название инженерной психологии. Появление этой области исследований было вызвано целым рядом случаев отказа человеко-машинных систем, произошедших по вине человека. Один из наиболее драматических, хотя и малоизвестных эпизодов случился в декабре 1941 года на американской военно-морской базе Перл-Харбор, когда инженеры, обслуживавшие один из первых образцов только что поступивших на вооружение радиолокаторов, отчетливо увидели на экране отраженные от приближающихся японских самолетов сигналы, но просто не поверили, что такое количество сигналов возможно, и решили отправить аппаратуру на ремонт вместо того, чтобы сообщить в штаб флота о возможном нападении.

Потребовалось целое десятилетие, чтобы научиться аккуратно описывать подобные ситуации. Для этого инженерными психологами наряду с теорией информации стала использоваться заимствованная из радиотехники и психофизики теория обнаружения сигнала (Wald, 1950). Благодаря ряду допущений, эта теория позволила описать работу оператора в задачах на обнаружение с помощью всего лишь двух параметров: чувствительности (а") и критерия (?). Если первый параметр описывает сенсорные возможности различения сигнала на фоне шума, то второй, как мы сказали бы сегодня, связан именно с когнитивными переменными: представлением о вероятности появления сигнала, а также оценкой относительной «цены» последствий двух возможных и неизбежных в ситуации обнаружения ошибок — пропуска сигнала и ложных тревог. На основании этих когнитивных переменных формируется готовность оператора при прочих равных условиях подтверждать наличие сигнала (низкий, или либеральный критерий) либо воздерживаться от такого подтверждения (высокий, или консервативный критерий). С формальной точки зрения, именно завышенное положение критерия помешало операторам в Перл-Харборе подтвердить приближение воздушных целей.

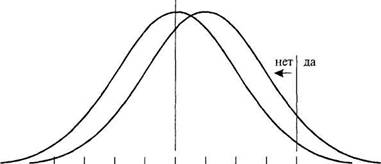

На рис. 2.1 показаны два идеализированных примера ситуации обна

ружения сигнала для простейшего случая, при котором появление сигна

ла не меняет разброса значений распределения шума, а просто сдвигает

это распределение вправо по оси величин регистрируемой в сенсорных

каналах активности. Распределение шума (аналог спонтанной сенсорной

активности) предполагается нормальным и стандартным, так что его сред

нее равно нулю, а стандартное отклонение — единице. Верхний график

описывает ситуацию обнаружения слабого сигнала, сдвигающего рас

пределение шума лишь на 0,5 его стандартного отклонения. Величина 0,5

и есть значение параметра чувствительности, обычно обозначаемого как

d' (произносится «дэ штрих»). Нижний график иллюстрирует обнаруже- „_

? =2,0 |

шум |

? = 0,0 нет да

? = 0,0 нет да

![]() -2,0 -1,5 -1,0 -0,5 0 0,5 1,0 1,5 2,0

-2,0 -1,5 -1,0 -0,5 0 0,5 1,0 1,5 2,0

d" сенсорное возбуждение

|

![]() -2,0 -1,5 -1,0 -0,5 0 0,5 1,0 1,5 2,0

-2,0 -1,5 -1,0 -0,5 0 0,5 1,0 1,5 2,0

а' сенсорное возбуждение

Рис. 2.1. Примеры использования аппарата теории обнаружения сигнала для описания ситуаций обнаружения слабого (А) и сильного (Б) сигналов на фоне шума.

98

ние более мощного сигнала. Расстояние между распределениями и, следовательно, чувствительность здесь больше: d' = 1,5. На обоих графиках также приведены по два возможных значения параметра критерия выбора ответа, ? («бета»). Оператор, принимающий более низкий из этих двух критериев (? = 0,0), будет сообщать о появлении сигнала всякий раз, когда величина сенсорной активности превышает среднее для распределения шума значение. Критерий ? = 2,0 означает, что о присутствии сигнала будет сообщаться, если величина сенсорной активности превысит два стандартных отклонения распределения шума.

Лейтмотивом множества исследований, проведенных с использованием аппарата теории обнаружения сигнала, стало представление о субоптимальности решений человека в ситуациях обнаружения. Особенно проблематичным оказалось постепенное ухудшение результатов обнаружения с увеличением времени наблюдения. Это ухудшение обычно состоит в ужесточении критерия принятия решений, что ведет к уменьшению числа ложных тревог, но чревато также и все более вероятными ошибками пропуска сигнала. Особенно яркими примерами этого явились сбои в обнаружении воздушных целей при охране наиболее важных государственных объектов системами противовоздушной обороны (ПВО) СССР и США в 1980-е годы. Так, в 1987 году немецкий летчик-любитель Маттиас Руст пересек со стороны Финляндии советскую границу, незамеченным долетел до Москвы и приземлился на Красной площади. Некоторое время спустя похожий инцидент произошел и в США, где недовольный налоговой политикой правительства фермер, захватив охотничье ружье, беспрепятственно долетел до центра Вашингтона, но разбился при попытке посадить свой самолет в саду Белого Дома. В обоих случаях операторы ПВО были «обезоружены» многолетним ожиданием вражеского нападения: стремясь избежать ложных тревог, они постепенно ужесточали критерии и в конце концов практически перестали замечать потенциально опасные цели.

О субоптимальности работы человека-оператора также говорили данные, собранные на основе экспертных оценок и представляемые в инженерной психологии в виде так называемых «МАВА—МAВА таблиц». Эти таблицы сравнивают между собой области деятельности и отдельные задачи, в которых человек оказывается лучше машины (Men-are-better-at) или, напротив, машина лучше человека (Machines-are-better-at). Так, задачи по обнаружению сигнала в силу колебаний внимания и отмеченной тенденции к завышению критерия принятия решений человеком лучше было бы доверить машине. С другой стороны, запоминание больших массивов информации и узнавание изображений первоначально считалось одной из областей, в которых человек был эффективнее машины. Разумеется, по мере развития компьютерных технологий количество таких областей стало постепенно сокращаться. Лишь наиболее сложные задачи, требующие глобальной оценки ситуации и выработки новых решений, причем часто на основании неполной информации, пока что прочно остаются в компетентности человека2.

![]() 2 Качество принимаемых человеком решений резко снижается в условиях стресса,

2 Качество принимаемых человеком решений резко снижается в условиях стресса,

вызываемого в первую очередь недостатком времени. Поэтому, например, в современной

ядерной энергетике предпринимаются специальные меры для того, чтобы в течение 10—

20 минут фиксировать развитие событий, не давая человеку возможности реализовать

слишком поспешные решения. Подобные задержки «на обдумывание», к сожалению,

невозможны в работе летчика или водителя, где действовать часто приходится в интерва

лах времени порядка долей секунды (за 1 секунду автомобиль, движущийся со скоростью

60 км/час, проезжает около 17м). 99

К компетенции человека продолжают и, безусловно, будут продолжать относиться задачи по принятию решения в условиях многокатегориального выбора. В отличие от рассмотренной задачи обнаружения сигнала, где основания для решения могут быть представлены в виде одной-един-ственной переменной, в подобных задачах существует несколько качественно различных систем критериев и несколько (обычно более двух) альтернативных решений. Специфически человеческим звеном здесь является прежде всего оценка относительной важности (весовых коэффициентов) различных критериев. Такая оценка всегда довольно субъективна и не может быть сведена к одному критерию, даже такому существенному, как критерий стоимости. Например, если речь идет о выборе проекта нового предприятия, то наряду с критерием стоимости строительства (возможно, в сочетании с ожидаемыми доходами — критерий cost/ benefit) важную роль в том или ином контексте могут играть также и другие критерии, такие как критерии престижности или экологической безопасности. Сравнительную оценку важности критериев в каждом конкретном случае может дать только лицо (группа лиц), принимающее решение.

Помимо самой оценки специфическая сложность задач многокритериального выбора состоит в том, что «при их рассмотрении все доводы "за" и "против" не присутствуют в уме одновременно; иногда присутствует одна часть, в другое время — иная, причем первая исчезает из вида. Следовательно, различные цели или склонности по очереди берут "верх" и появляется неопределенность, которая озадачивает и мучает нас»3. В качестве простейшей исчерпывающей процедуры получения весовых коэффициентов отдельных критериев и их агрегации в общую оценку альтернатив в литературе по методам поддержки принятия решений (Ларичев, 2002) рекомендуется следующая последовательность шагов:

![]() 3 Эта цитата взята из письма Бенджамина Франклина, датированного сентябрем 1772 года. Франклин рекомендует далее записывать аргументы «за» и «против» на левой и правой стороне листа: «Когда я имею все это в поле зрения, я пытаюсь оценить их веса; если я найду два, каждый на другой стороне, которые кажутся мне равными, я их вычеркну... Если я считаю, что некоторые два довода "за" равны трем доводам "против", я вычеркиваю все пять; продолжая таким образом, я нахожу со временем, где находится баланс». Эти соображения можно считать эскизом современных компьютерных программ, поддерживающих процессы принятия решений (см. 8.4.2). Проблемы данной области связаны с нетранзитивным и нелинейным характером человеческих предпочтений, накладывающим ограни-100 чения на математические операции с балльными оценками (см. Ларичев, 2002).

3 Эта цитата взята из письма Бенджамина Франклина, датированного сентябрем 1772 года. Франклин рекомендует далее записывать аргументы «за» и «против» на левой и правой стороне листа: «Когда я имею все это в поле зрения, я пытаюсь оценить их веса; если я найду два, каждый на другой стороне, которые кажутся мне равными, я их вычеркну... Если я считаю, что некоторые два довода "за" равны трем доводам "против", я вычеркиваю все пять; продолжая таким образом, я нахожу со временем, где находится баланс». Эти соображения можно считать эскизом современных компьютерных программ, поддерживающих процессы принятия решений (см. 8.4.2). Проблемы данной области связаны с нетранзитивным и нелинейным характером человеческих предпочтений, накладывающим ограни-100 чения на математические операции с балльными оценками (см. Ларичев, 2002).

6. Выбрать в качестве лучшей альтернативу, получившую наибольшую общую оценку.

Развернувшиеся во второй половине 20-го века работы по автоматизации отдельных функций и областей деятельности человека в целом проходили под лозунгом его освобождения от тяжелых и несвойственных ему сенсомоторных задач. Предполагалось, что за человеком-оператором постепенно останутся только функции когнитивного контроля за работой технических систем. С развитием информатики, электроники и когнитивных исследований стали создаваться системы относительно полного технического контроля и исполнения действий (такие как FlightManagementSystems, используемые в военной и гражданской авиации для автоматического управления основными режимами полета). Постоянное увеличение степени сложности техники требовало от человека-пользователя сопоставимых, все более серьезных усилий по обучению и пониманию работы систем. Одновременно, из-за технических и финансовых ограничений автоматизации часто подвергались относительно изолированные фрагменты деятельности.

Результаты подобной фрагментарной замены человека компьютерными системами часто оказывались неудовлетворительными. В этих полуавтоматизированных системах скорее сам человек оказался под контролем автоматов, чем наоборот. Известный отечественный инженерный психолог Б.Ф. Ломов (например, Ломов, 1966) еще в начале 1960-х годов предупреждал об опасности такого развития, выдвинув вместе со своими коллегами принцип «активного оператора». Главным недостатком, или, по словам современной английской исследовательницы Лизанн Бэйнб-ридж, иронией автоматизации стало сегодня то, что оператору или, например, летчику временами приходится действовать в еще более экстремальном диапазоне нагрузок, чем прежде. Относительно легкие задачи упростились за счет их автоматизации, тогда как трудные задачи стали более сложными в силу усложнения самих человеко-машинных систем, а также из-за того, что решать их приходится внезапно и из состояния недонагрузки. При внезапных повышенных нагрузках в условиях жестких временных ограничений возникает состояние острого стресса, меняющее протекание практически всех познавательных процессов. Стресс, в частности, ведет к эффекту так называемого туннельного зрения — резкому ограничению размеров функционального поля зрения и фиксации внимания на отдельных деталях, а не на сцене в целом (см. 4.2.2 и 9.4.3).

Центральной проблемой сегодня становится выравнивание этого дисбаланса, то есть избирательная поддержка (вплоть до полной замены4)

![]() 4 Речь идет о временной передаче управления автоматам. Примером могут служить

4 Речь идет о временной передаче управления автоматам. Примером могут служить

современные системы предотвращения столкновения с земной поверхностью (GCAS—

GroundCollisionAvoidanceSystem), используемые в военной авиации. Эти системы оцени

вают параметры движения самолета и с учетом рельефа местности, а также времени реак

ции пилота автоматически уводят самолет в случае необходимости из опасной зоны. 101

человека в тех случаях, когда он находится на пределе своих возможностей, и, напротив, эпизодическая передача ему дополнительных функций (например, ручного управления самолетом) в периоды потенциально опасной недонагрузки. В результате возникает новая задача адаптивной автоматизации. Она предполагает психологический мониторинг функционального состояния человека с текущей оценкой степени и характера его внимания, содержаний восприятия, понимания актуальной ситуации (или «осознания ситуации» — situation awareness) и, насколько возможно, также непосредственных намерений. Хотя в общем виде эта задача еще очень долго не будет иметь решения, ее частные решения, похоже, возможны; они опираются на результаты прикладных когнитивных исследований и также обсуждаются на страницах этой книги (см. 3.4.2 и 7.4.3).

Инженерную психологию всегда интересовала задача нахождения некоторого единого языка для описания работы человека и функционирования технических систем. Наиболее подходящим языком такого описания вначале считалась теория информации. С накоплением опровергающих это мнение данных (см. 2.1.3), а затем и с возникновением задачи адаптивной автоматизации стали меняться акценты, так что иногда сами машины стали описываться в антропоморфных терминах как продукты (артефакты) деятельности человека. Так, датчанин Йене Расмуссен (Rasmussen, 1986) предложил рассматривать все компоненты человеко-машинных систем в контексте трех, известных из теории деятельности вопросов: «для чего?», «что?» и «как?» (см. 1.4.3). Им же была предложена трехуровневая модель операторской деятельности, в которой на самом низком уровне поведение находится под контролем автоматизированных навыков, на втором — хранящихся в памяти правил и на третьем — знаний о ситуации. Данная модель используется прежде всего для классификации ошибок оператора. В зависимости от уровня возникновения такие ошибки влекут за собой разную степень ответственности. Например, авиадиспетчер может просто перепутать похожие команды (неудачно расположенные рядом кнопки) или же, подумав, сознательно направить два самолета на одну и ту же посадочную полосу (см. 9.1.3).

Недостатком этой и аналогичных ранних моделей является то, что они были совершенно недостаточно обоснованы с точки зрения фундаментальных исследований. В частности, их авторы полностью игнорировали нейрофизиологические и нейропсихологические данные, столь важные, как становится очевидно в последние годы, для создания более реалистических представлений о специфических особенностях и ограничениях возможностей человека в его взаимодействии с техническими системами (см. 7.4.3 и 8.4.3). Эти данные впервые заложили теоретико-экспериментальную основу для прикладных исследований на границе психологии и новых технологий, подтверждая старое правило «Нет ни-102 чего практичнее хорошей теории». Кроме того, классическая для этой

области проблематика стресса и утомления обусловила постоянный диалог исследований когнитивной организации с анализом функциональных состояний (см. 9.4.3). Таким образом, развитие инженерной психологии и такого нового ее раздела, как когнитивная эргономика (дисциплина, занимающаяся оптимизацией взаимодействия человека и компьютерных систем), сегодня находится под прямым влиянием исследований в широкой области когнитивных и аффективных нейронаук.

2.1.3 Поиски ограничений пропускной способности

Вернемся к ситуации, в которой оказались исследования познавательных процессов в 1950-е годы. Основные экспериментальные работы этого периода имели прикладной характер и были направлены на возможно более точное описание ограничений информационной пропускной способности человека. К числу основных феноменов, иллюстрирующих такие ограничения, обычно относят следующие:

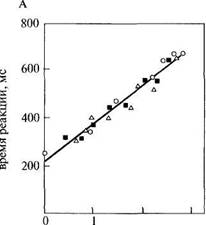

В последующих главах эти феномены будут рассмотрены нами в контексте современных представлений о возможных ограничениях познавательных процессов. Мы остановимся здесь подробно на самом первом в списке этих феноменов. Еще в 1885 году один из учеников Вундта Меркель установил, что время реакции выбора («В-реакция» Дондерса: ? стимулов и « реакций) линейно зависит от логарифма числа стимулов. Этот же результат был получен почти 70 лет спустя американцами Хиком и Хэйменом, которые объяснили его как следствие зависимости времени реакции от количества средней информации:

ВР = а+ в*Н,

где а — параметр, задаваемый временем передачи информации на входе и выходе канала; в — величина, обратная пропускной способности канала, и ? — среднее количество информации, определяемое по формулам, приведенным в начале этой главы. Это соотношение, получившее ЮЗ

название закона Хика, сохраняется при различных способах варьирования средней информации: изменении числа альтернатив, изменении абсолютных вероятностей при постоянном числе альтернатив и, наконец, введении различных вероятностей следования одних сигналов за другими (рис. 2.2А).

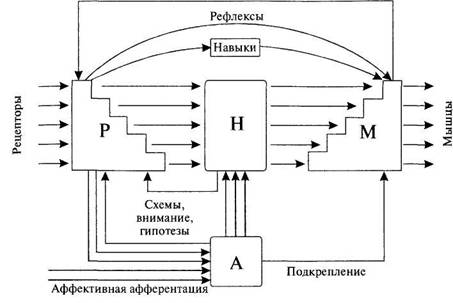

В рамках инженерно-психологических исследований ограничений избирательного внимания и непосредственной памяти Дональд Брод-бент (ученик Бартлетта и бывший военный летчик, участвовавший в воздушной битве за Англию) опубликовал в 1954 году статью под названием «Механическая модель внимания и непосредственной памяти человека», где впервые описал внимание как фильтр, осуществляющий отбор релевантной с точки зрения задачи сенсорной информации. Этот фильтр расположен на входе в непосредственную память — «центральный информационный канал с ограниченной пропускной способностью» — и осуществляет отбор релевантной информации по принципу «все или ничего» (рис. 2.3). Близкие идеи легли в основу монографии Бродбента «Восприятие и коммуникация», вышедшей в свет в 1958 году. В этой работе был обобщен гигантский объем данных, полученный в рамках информационного подхода. Это развитие целиком соответствовало неопозитивистским канонам — как и в необихевиоризме автором проводился формальный анализ наблюдаемых переменных, а человек трактовался как относительно закрытый «черный ящик». Очерки психологии с точки зрения статистической теории связи появились в конце 1950 — начале 1960-х годов. Однако это было время, когда информационный подход стал подвергаться серьезной критике.

2 3 0 1

количество информации, бит

Рис. 2.2. Закон Хика — зависимость времени реакции выбора от информативности сиг-104 налов: А. Первоначальные данные; Б. Данные, собранные за последующие 10 лет.

|

Рис. 2.3. Одна из первых информационных моделей памяти и внимания, предложенная Бродбентом (Broadbent, 1958).

Прежде всего, установленные законы стали обрастать дополнениями и оговорками, учитывающими субъективную значимость и естественность различных ситуаций. Так, едва ли не центральной проблемой инженерной психологии в эти годы стала проблема естественного соответствия сигналов и ответов испытуемого: время реакции ускоряется, если, например, на акустический сигнал, подаваемый справа, нужно отвечать правой рукой. Разумеется, этот эффект можно попытаться объяснить строго физикалистски, проследив движение информации по нейрофизиологическим путям — от правого уха в контрлатеральное левое полушарие, которое, в свою очередь, иннервирует преимущественно правую часть тела. Однако такое объяснение может быть легко поставлено под сомнение. Если попросить испытуемого скрестить руки, то на сигналы, поступающие справа, он начинает быстрее отвечать левой рукой. Существенной, таким образом, оказывается близость сигналов и ответов в феноменальном, а не физическом пространстве5. Встает типичный для собственно когнитивной психологии вопрос о форме репрезентации — о том, каким образом могут быть внутренне представлены внешнее окружение, сигналы и схема тела.

Исследования времени реакции выбора постепенно выявили чрезвычайно пеструю картину, совершенно не укладывающуюся в прокрус-

![]() 5 Надо сказать, что подчеркивание роли таких переменных, как значимость и естественность, типично как раз для «аристотелевского», а не «галилеевского» способа образования понятия (см. 1.3.1).

5 Надо сказать, что подчеркивание роли таких переменных, как значимость и естественность, типично как раз для «аристотелевского», а не «галилеевского» способа образования понятия (см. 1.3.1).

105

106

тово ложе закона Хика (рис. 2.2А). Для разных типов сигналов и ответов, а также для различных их комбинаций параметры получаемых зависимостей оказались разными. Наиболее «неудобными» являются те случаи, в которых вообще не было обнаружено сколько-нибудь выраженной зависимости времени реакции от количества информации в идентифицируемых сигналах (функции «ж», «з», «и», «к» на рис. 2.2Б). При интерпретации этих данных с помощью закона Хика получался бессмысленный вывод о безграничной пропускной способности. Единственный закон, который был подтвержден этими исследованиями, состоял в демонстрации почти безграничной адаптируемости человека к подобным искусственным условиям: в одной из британских работ по времени реакции выбора, продолжавшейся в течение пяти месяцев, число проб превысило 45 000, но время реакции испытуемого все еще продолжало снижаться.

В 1956 году видный американский психолингвист и последователь Хомского Джордж Миллер опубликовал ставшую классической работу «Магическое число семь, плюс или минус два» (см. Миллер, 1964). Он показал, что ограниченность объема кратковременной памяти определяется совсем не количеством объективно измеренной в битах информации, а относительно небольшим количеством (порядка 7) «единиц», или «кусков» («чонков» от англ. chunks) субъективной организации материала. В качестве подобных единиц организации материала в непосредственной памяти могут выступать буквы или цифры, слова или, например, короткие предложения. Количество информации будет во всех этих случаях совершенно различным. Размеры этих единиц, как показал Миллер в опытах на себе, меняются в процессе обучения. Так, для человека, совершенно незнакомого с вычислительной техникой, слово «IBM» представляет собой последовательность трех единиц, тогда как для всех лиц, знающих, что это название крупнейшей компьютерной фирмы, — всего лишь одну единицу.

Точно так же в исследовании зрительного различения было установлено, что комбинация перцептивных признаков, которая с логической точки зрения не меняет неопределенность стимулов (а следовательно, не меняет и количество информации), тем не менее, приводит к значительному изменению пропускной способности. Так, в случае одномерных стимулов, варьирующих только по цвету, яркости или величине, испытуемый может перерабатывать 2,75 бита информации, чему соответствуют безошибочные различения и категоризация примерно 7 стимулов. Если же стимулы меняются одновременно по всем трем параметрам, причем меняются полностью коррелированным (избыточным) образом, так что формально по-прежнему есть только одно стимульное измерение, количество передаваемой информации возрастает до 4,11 битов. Это означает успешную категоризацию уже 17 стимулов. После таких результатов необходимость изучения внутренней репрезентации цвета, яркости, величины и других перцептивных категорий станови-

лась понятной даже наиболее позитивистски ориентированным пред-

ставителям информационного подхода.

Важную роль в создании методологического климата, сделавшего

возможным переход к когнитивной психологии, сыграл принцип кон

вергирующих операций Гарнера, Хэйка и Эриксена (Garner, Hake &

Eriksen, 1956), означавший либерализацию и даже ревизию требований

ортодоксального неопозитивизма (см. 1.3.2). Основная мысль состояла

в том, что изучать можно и то, что не является непосредственно наблю

даемым. Границы подобного, «скрытого за поверхностью» регистрируе

мых событий предмета исследований, лучше всего могут быть намечены

при движении по различным, но сходящимся (конвергирующим) на

правлениям. Например, если обнаруживается сходство оценок продол

жительности работы некоторого гипотетического внутреннего механизма,

полученное с помощью двух или большего числа независимых методичес-

ких процедур, то можно допустить, что такой механизм действительно

существует — даже если результаты отдельных методик для этого допу

щения недостаточно убедительны. Авторы попытались в первую очередь

разделить сенсорные аспекты восприятия и чисто моторные реакции,

заменив радикальное операционалистское утверждение: «восприятие =

определенный способ реагирования на сенсорную стимуляцию» на бо-

лее осторожное: «восприятие = некоторое внутреннее событие, кото-

рое может проявляться в моторных реакциях, но принципиально от

них отлично».

В результате психология восприятия была вновь выделена в качестве

самостоятельной области исследований. Поскольку понятия гештальт-психологии казались слишком широкими и слишком менталистскими, была предпринята попытка использовать для количественного описания структуры восприятия аппарат статистической теории связи. «Многие из гештальтистских принципов, — писал один из ведущих представителей информационного подхода Фрэд Эттнив, — связаны с количеством информации. Хороший гештальт — это форма с более высокой степенью избыточности. Такие законы перцептивной организации, как законы близости, сходства, хорошего продолжения и общей судьбы, совершенно очевидно относятся к ситуациям, в которых происходит уменьшение неопределенности» (Attneave, 1965, р. 117). Однако применение теории информации для описания перцептивной организации также натолкнулось на трудности. Искусственным было уже требование, согласно которому наблюдатель заранее должен знать весь набор возможных событий. Гештальтпсихологи, например, всегда утверждали, что восприятие является процессом, который строится «здесь и теперь»: в конкретной ситуации и вне зависимости от прошлого опыта.

Следует отметить, что еще в 1950 году английский кибернетик До

нальд М. Маккай (МасКау, 1950) предупреждал о принципиальных про

блемах с применимостью статистической теории связи в психологии,

1 предлагая создать или, по крайней мере, подумать о создании теории, в

которой информация в некотором сообщении оценивалась бы числом когнитивных операций, которые осуществляются при моделировании

его содержания. Маккай даже создал вариант применимой для психологических целей методики измерения «структурной информации». Как и ряд аналогичных попыток, его теория структурной информации не получила сколько-нибудь широкого распространения (за исключением отдельных исследований восприятия формы и цвета — см. 3.3.1). Не получил широкого распространения и сам кибернетический подход, предложивший интересные, но очень математизированные средства описания процессов управления в сложных динамических системах. Напротив, чрезвычайно популярной стала общая идея реконструкции организмом своего окружения и мысленной работы с этой внутренней моделью. Эта идея легла в основу следующей метафоры экспериментальной психологии.

Новый подход к анализу психических процессов, возникший в начале 1960-х годов, имел длительную предысторию. В 1894 году ученик Гельм-гольца Генрих Герц писал: «Отношение динамической модели к системе, моделью которой она считается, это в точности отношение образов вещей, которые создает наш разум, к самим вещам... Согласованность между разумом и природой может быть, таким образом, приравнена согласованности двух систем, являющихся моделями друг друга; мы даже могли бы объяснить эту согласованность, предположив, что наш разум способен создавать динамические модели вещей и работать с ними» (Hertz, 1894, S. 177). Через полстолетия эту мысль развил сотрудник Бартлетта и один из создателей инженерной психологии Кеннет Крэйк: «Если организм несет в голове мелкомасштабную модель внешнего окружения и своих возможных действий, он способен проверять различные альтернативы, определять наилучшие из них, реагировать на будущее развитие ситуации и вообще во всех отношениях вести себя более полноценно, безопасно и компетентно, попадая в сложные условия» (Craik, 1943, р. 61 )6.

Анализируя «внутренние модели» пространственного окружения, мы сразу же обнаруживаем, что они имеют «матрешечную» организацию, то есть обычно состоят из нескольких рекурсивно вложенных друг в

![]() 108

108

6 Элегантную формулировку сути когнитивного подхода в нейрофизиологии (не используя, впрочем, термина «когнитивный») несколько позже предложил H.A. Бернштейн: «Мозговое отражение (или отражения) мира строится по типу моделей Мозг не запечатлевает поэлементно и пассивно вещественный инвентарь внешнего мира.., но налагает на него те операторы, которые моделируют этот мир, отливая модель в последовательно уточняемые и углубляемые формы» (1966, с. 287).

друга репрезентаций. Например, мы можем представить себе карту северо-востока России, так что Санкт-Петербург будет при этом представлен чем-то вроде точки, а затем развернуть эту «точку» в полномасштабное пространственное представление и т.д. (см. 6.3.2). Рекурсивный характер имеют наши представления о других людях и их знаниях о нас (см. 7.4.1). Наконец, рекурсивность типична для нашего языка, что подчеркивалось в теории порождающей грамматики Хомского (см. 1.3.3 и 8.4.3). Используя эту теорию, можно было сделать следующий шаг — объявить различия всех этих форм репрезентации поверхностными и постулировать единый абстрактный формат представления знаний на уровне глубинных структур, допускающих алгоритмическое описание. Вот почему в начале 1960-х годов процессы познания стали трактоваться по аналогии с процессами вычислений в компьютере. Понимание того, что человек активно «перерабатывает информацию», строя внутренние модели (репрезентации) окружения, означало переход от информационного подхода в узком смысле слова к когнитивной психологии.

Эта компьютерная метафора когнитивной психологии открыла принципиально новые теоретические возможности, заменив характерное для психологии 19-го — первой половины 20-го веков представление об энергетическом обмене организма со средой на представление о значительно более быстром и гибком информационном обмене. Так, Вундт и его современники полагали, что только что открытый закон сохранения энергии требует признания строгого психофизического параллелизма, то есть признания — в полном согласии с картезианской философской традицией (см. 1.1.1 и 9.1.3) — полной независимости (в смысле причин и следствий) телесных и ментальных событий. Но вычислительное устройство, потребляя весьма незначительное количество энергии, может управлять огромными механизмами. Поэтому требование психофизического параллелизма перестало вдруг казаться строго обязательным. Далее, хотя трудно сказать, какие процессы лежат в основе некоторой чисто психической работы, например, восприятия картины Рембрандта, можно легко представить компьютер или специализированный электронный прибор, осуществляющий переработку информации, которая заканчивается адекватным ситуации ответом.

Первыми работами нового направления можно считать исследования процессов образования искусственных понятий Джеромом Бруне-ром и сотрудниками, а также работы Ньюэлла, Саймона и Шоу, создавших ряд машинных моделей мышления, в том числе «Логик—теоретик» и «Универсальный решатель задач». Общими чертами этих работ являются не только массивное использование формально-логического анализа (например, используемый в монографии Брунера теоретический аппарат совпадает с правилами индукции Дж.С. Милля), но и восстановление авторитета более ранних, «добихевиористских» исследований познания. В случае Ньюэлла и его коллег это были Отто Зельц и геш-тальтпсихология, а в случае Брунера — вюрцбургская школа и диссер-

ПО

тационная работа Кларка Халла 1920 года по формированию понятий, выполненная на материале китайских иероглифов. Отдавая должное другим влияниям, Брунер писал позднее, что на него произвело в эти годы глубокое впечатление знакомство с традицией изучения познания в советской психологии. Действительно, в его работах отчетливо выступает интерес к анализу развития познавательных процессов, которые он вслед за Бартлеттом, Леонтьевым, Гальпериным и Пиаже связывает с формированием внешней деятельности. При этом, впрочем, он, как и Выготский, подчеркивает моменты символьного взаимодействия ребенка с другими людьми, а не чисто сенсомоторные компоненты.

Использование «менталистской» терминологии в когнитивной психологии было обусловлено вначале эвристическими соображениями; она оказалась необходимой потому, что сложность рассматриваемых феноменов не позволяла дать их осмысленную интерпретацию в других терминах. Переход к неоментализму сопровождался попыткой осмысления философских проблем, которые он за собой влечет. Практически в течение одного 1960 года появилось несколько работ, в которых ставился вопрос о характере объяснения активности познавательных процессов. Эти работы содержат предположение, что проблема бесконечного регресса к гомункулусам, поставленная ранее в споре между Толменом и Газри (она известна также как проблема Юма — см. 1.1.1 и 1.3.3), может быть обойдена, если предположить, что процессы переработки информации организованы в иерархические, все более абстрактные структуры, а сам гомункулус выполнен из нейроноподобных элементов.

В статье под названием «В защиту гомункулусов» Фрэд Эттнив (Attneave, 1961) отмечает, что если на более ранних уровнях переработки информации будут выполняться некоторые функции гомункулуса, то в конечном счете для моделирования познавательной активности во всей ее сложности потребуется система с конечным числом уровней. Блок-схема переработки информации человеком, центральное место в которой занимает гомункулус (блок Н), показана на рис. 2.4. Блок H является местом конвергенции сенсорной и аффективно-оценочной информации; его выход представляет собой произвольное поведение, в то время как рефлексы и автоматизированные навыки реализуются другими структурами. Его активность необходима для осознания, а также для всякого сколько-нибудь продолжительного запоминания информации. Эттнив легко включает в свою модель данные об ограниченности внимания и непосредственной памяти, считая, что вход в блок H ограничен 7+2 единицами предварительно организованного перцептивной системой (блок Р) материала. Совершенно очевидно, что Эттнив вкладывает в уже имевшиеся к тому времени информационные модели познавательных процессов традиционное для психологии сознания содержание. Статья завершается призывом пересмотреть вопрос о научной респектабельности гомункулуса (см. 4.4.2 и 5.2.3).

Проприоцепция

Рис. 2.4. Модель переработки информации человеком по Эттниву (Attneave, 1961). ? — перцептивная система, А — аффективно-оценочная система, ? — гомункулус, M — моторная система

Сдвиг от необихевиоризма к неоментализму когнитивной психологии был зафиксирован и в известной книге Дж. Миллера, Н. Галантера и К. Прибрама «Планы и структуры поведения» (русский перевод — Миллер, Галантер, Прибрам, 1964). Авторы описали элементарную структуру действия, включив в нее операцию когнитивной оценки, TEST. Эта структурная ячейка действия получила название TOTE {TEST-OPERATE—TEST—EXIT). Этими же авторами также еще раз была выдвинута задача изучения «центральных процессов», с помощью которых можно заполнить «пропасть между стимулами и реакциями». Образы были уподоблены планам, или компьютерным программам, иерархическая организация которых допускает возможность «самопрограммирования» и позволяет, по мнению авторов, обойтись без гомункулуса. Наряду с другими аналогичными призывами к изучению «центральных процессов», это был не просто субъективный бихевиоризм, но уже когнитивная психология, в ее специфической форме, подчеркивающей аналогию между внутренними репрезентациями и программами вычислений.

Значительная часть развернувшихся с конца 1950-х годов исследований склонялась к другой версии компьютерной метафоры, связанной с выявлением и анализом возможных структурных блоков переработки информации и принципов их объединения в единую функциональную архитектуру. Не случайно большинство этих работ было направлено на

111

выделение процессов и видов памяти, аналогичных процессам преобразования и блокам хранения информации вычислительных устройств. Благодаря экспериментам англичанина Брауна и американцев Питерсо-нов, здесь, прежде всего, удалось установить критическую роль активного повторения для всякого продолжительного сохранения информации: если после показа некоторого материала (цифры, слоги и т.д.) для запоминания испытуемый должен выполнять какую-либо интерферирующую активность (например, отнимать тройки от некоторого достаточно большого числа), то уже через 10—20 секунд вероятность правильного воспроизведения приближается к нулевой отметке7.

Джордж Сперлинг (Sperling, 1960), а несколько позднее и другие авторы, использовав методику частичного отчета (инструкция, определяющая характер воспроизведения материала, предъявляется в этой методике уже после окончания предъявления самой информационной матрицы), пришли к выводу, что сразу после кратковременного предъявления зрительная информация примерно в течение трети секунды сохраняется в виде относительного полного сенсорного образа, после чего она исчезает или переводится в какую-то другую, вероятнее всего, вербальную форму (см. 3.2.1). Предположение об обязательном участии вербального повторения в переводе информации в долговременную память, то есть во всяком, сколько-нибудь продолжительном запоминании материала (включая абстрактные фигуры), получило название гипотезы вербальной петли (см. 5.2.1).

Для объяснения этих данных сначала Н. Во и Д. Норман (Waugh & Norman, 1965), а затем Р. Аткинсон и Р. Шиффрин (русский перевод — Аткинсон, 1980) предложили модель, в которой выделили три блока переработки информации в памяти человека: сенсорные регистры (например, «ультракороткая зрительная память» из работ Сперлинга), первичную память (кратковременная память с ограниченным объемом и вербальным повторением в качестве способа сохранения информации) и вторичную память (долговременная семантическая память с очень большим объемом пассивно сохраняемой информации). Легко видеть, что эта модель в общих чертах описывает архитектуру универсальной цифровой вычислительной машины (см 5.2.1 ). Вместе с тем, она вполне тради-ционна. Так, различение первичной и вторичной памяти можно найти уже у Джеймса или еще раньше у немецкого физиолога Экснера. Первичной памятью они называли непрерывное сохранение представления в пределах поля сознания, вторичной — повторное возвращение представления в сознание, после того как оно его покинуло. Первичная (кратковременная) память оказывается, таким образом, удивительным

![]() 7 Полученные этими авторами результаты совпали с данными исследования А Дани-елса (Daniels, 1895), выполненного в конце 19-го века Его интересовала продолжитель-112 ность сохранения впечатления в «поле сознания»

7 Полученные этими авторами результаты совпали с данными исследования А Дани-елса (Daniels, 1895), выполненного в конце 19-го века Его интересовала продолжитель-112 ность сохранения впечатления в «поле сознания»

образованием, одновременно имеющим сходство с сознанием, гомункулусом, каналом связи и микропроцессором компьютера!

К числу других проблем этих ранних исследований относились вопросы о локализации и модусе работы селективных фильтров (внимания), осуществляющих отбор релевантной и подавление иррелевантной информации, последовательной или параллельной организации процессов в задачах поиска, характера взаимодействия восприятия и памяти при распознавании конфигураций. Так, ученица Бродбента Энн Трисман предположила, что перцептивные процессы разворачиваются последовательно на нескольких уровнях обработки информации, начиная с анализа сенсорных признаков материала и кончая анализом семантических. Такие работы представляли не только абстрактный научный интерес. Одной из практических проблем, изучению которой были посвящены в середине 20-го века десятки экспериментов, стала проблема вечеринки {cocktailpartyproblem) — механизмы выделения релевантного речевого сообщения на фоне множества других одновременно ведущихся разговоров. Исследования показали, что отбор осуществляется преимущественно на основании элементарных сенсорных признаков, таких как определенное пространственное положение источника или специфический тембр голоса8. Было установлено, что семантическая связность сообщения также способствует лучшей настройке на релевантный канал (см. 4.1.2).

Значительное число работ 1960-х годов было посвящено описанию организации семантической информации в памяти. Одна из методик состояла в анализе группировки (кластеризации) словесного материала по семантическим категориям в задаче полного воспроизведения. Устойчивые ассоциативные связи между словами изучались с помощью методики свободных ассоциаций (см. 6.1.2). Еще один подход был связан с анализом феномена «на кончике языка», описанного Джеймсом, а также, в литературной форме, А.П. Чеховым (в рассказе «Лошадиная фамилия»). Браун и Макнил давали испытуемым словарные определения редких слов. В тех случаях, когда испытуемые не могли назвать слово, но утверждали, что знают его и вот-вот вспомнят, их просили угадать число слогов, примерное звучание, положение ударения, отдельные буквы и т.д.

![]() 8 Несмотря на легкомысленное название, «проблема вечеринки» возникла в серьезном контексте ведения воздушного боя, когда пилоты общались на одной радиоволне и нужно было научиться выделять в хоре голосов релевантное сообщение В разгар «холодной войны» данные о селективности внимания использовались в СССР при глушении западных радиостанций Поскольку женские и мужские голоса существенно отличаются базовой частотой, для глушения передач в какой-то момент стал применяться акустический «салат» из одновременно звучащих мужских и женских голосов Возникающая при этом маскировка была более полной, чем при использовании так называемого белого шума, в равной степени включавшего разные акустические частоты В настоящее время наблюдается новый всплеск интереса к этим механизмам, поскольку технические системы распознавания речи оказались неспособными к решению «проблемы вечеринки» и пытаются одновременно обрабатывать все, что произносится в их окружении (см 7 4 3)

8 Несмотря на легкомысленное название, «проблема вечеринки» возникла в серьезном контексте ведения воздушного боя, когда пилоты общались на одной радиоволне и нужно было научиться выделять в хоре голосов релевантное сообщение В разгар «холодной войны» данные о селективности внимания использовались в СССР при глушении западных радиостанций Поскольку женские и мужские голоса существенно отличаются базовой частотой, для глушения передач в какой-то момент стал применяться акустический «салат» из одновременно звучащих мужских и женских голосов Возникающая при этом маскировка была более полной, чем при использовании так называемого белого шума, в равной степени включавшего разные акустические частоты В настоящее время наблюдается новый всплеск интереса к этим механизмам, поскольку технические системы распознавания речи оказались неспособными к решению «проблемы вечеринки» и пытаются одновременно обрабатывать все, что произносится в их окружении (см 7 4 3)

113

Оказалось, что часто они оказывались в состоянии воспроизвести эту фрагментарную информацию об отдельных признаках слова (см. 7.1.3). Внутренняя репрезентация значений слов стала описываться как многомерный вектор свойств. В одной из первых теорий значения когнитивной психологии Катц и Фодор описали значение в терминах атомарных, иерархически организованных признаков, или предикатов: «быть мужчиной», «быть человеком», «быть живым существом» и т.д.

Так, например, понятие ХОЛОСТЯК задается, согласно теории Кат-ца и Фодора, сочетанием всего лишь трех дихотомических признаков: «быть мужчиной (+)», «быть взрослым (+)», «быть женатым (—)». Данный подход, казалось бы, наконец-то открывал путь к чисто автоматическому, машинному вычислению истинности понятий и составленных из них логических высказываний, пропозиций (см. 2.2.3). Вместе с тем, подобная абстракция исключала из рассмотрения многие пограничные или особые случаи, определяемые такими факторами, как социокультурные традиции и предписания. Можно ли, в самом деле, считать «холостяками» иерархов римской католической церкви, хотя в их случае выполняется приведенное выше требование сочетания элементарных семантических признаков? Точно так же, можно ли считать «холостяками» лиц нетрадиционной сексуальной ориентации или же членов формально незарегистрированных гетеросексуальных пар, которые длительное время живут вместе со своими партнерами? Очевидно, при определении даже такого простого понятия перечисление признаков оказывается недостаточным и приходится учитывать более широкий контекст — специфические особенности социокультурного института женитьбы/замужества (см. 6.3.1).

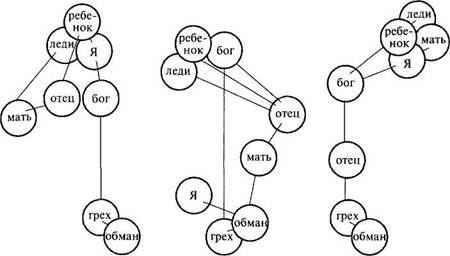

Близость этих когнитивных теорий значения структуралистским представлениям создателей экспериментальной психологии и философии 18—19-го веков неоспорима. Уже для Вундта, впрочем, всякое воспоминание было интегрировано в системе координат его трехмерной теории эмоций: «удовольствие — неудовольствие», «напряжение — расслабление», «возбуждение — успокоение». Ее более современным аналогом может служить трехмерное семантическое пространство конно-тативных (то есть аффективных) значений, построенное в 1950-е годы с помощью статистической процедуры факторного анализа Чарльзом Осгудом и его сотрудниками (Osgood, Suci & Tannenbaum, 1957). Эта модель имеет очень похожие на вундтовские координаты: «хороший — плохой» (шкала оценки), «сильный — слабый» (шкала силы), «активный — пассивный» (шкала активности). На базе модели была создана методика семантического дифференциала, в которой значение слов оценивалось всего лишь по трем отмеченным шкалам — оценки, силы и активности. Использовав данную методику, Осгуд и его коллеги продемонстрировали, например, каким образом меняется отношение к словам, имеющим аффективное значение, у пациентки с синдромом раз- двоения личности (рис. 2.5).

Рис. 2.5. Изменения в оценке коннотативного (аффективного) значения группы понятий у пациентки с раздвоением личности до (А), во время (Б) и после (В) кратковременного обострения состояния (по· Osgood, Suci & Tannenbaum, 1957).

Надо сказать, что сам Осгуд, несмотря на его активное участие в первых междисциплинарных конференциях когнитивистов и значительный фактический вклад в когнитивную науку, представлял необихевиористское направление психолингвистики. Поэтому он трактовал значение как осуществляющийся на основе ассоциативных связей внутренний медиаторный ответ (rj на внешний стимул. То, что Осгуд и другие психолингвисты середины 20-го века описывал как изменение отношения к понятиям, для представителей только что возникшей когнитивной психологии означало изменение внутренней структуры репрезентации понятий в семантической памяти. Это различие еще раз оттеняет специфику когнитивного подхода, с его общей неоменталистской ориентацией, отрицающей исследование моторики и поведения в целом. Современные психологические, а также и нейрофизиологические исследования различных форм представления знания будут подробно рассмотрены нами в следующих главах. Для новых работ становится характерным известный плюрализм — объединение этих и ряда других, первоначально противопоставлявшихся друг другу точек зрения и методических подходов (см. 6.1.3 и 9.4.1).

115

Итоги первого этапа развития когнитивной подхода были подведены в книге Улрика Найссера «Когнитивная психология», вышедшей в свет в 1967 году. Уже во введении он пишет, что конструктивный характер наших познавательных процессов является фундаментальным фактом. Задача когнитивной психологии состоит в том, чтобы понять, каким образом «воспринимаемый, воспоминаемый и осмысляемый мир порождается из такого малообещающего начала, как конфигурация рети-нальной стимуляции или узоры звукового давления в ухе» (Neisser, 1967, р. 4). Заимствуя идею у Фрейда (работа «Влечения и их превращения»), Найссер, пишет, что «эту книгу можно было бы назвать "Стимульная информация и ее превращения". "Познание" — это обобщенное название для всех процессов, посредством которых сенсорная информация трансформируется, редуцируется, усиливается, сохраняется, извлекается и используется. Оно имеет отношение к этим процессам даже тогда, когда они разворачиваются в отсутствие релевантной стимуляции, как это имеет место при воображении или галлюцинациях. Такие термины, как ощущение, восприятие, воображение, запоминание, припоминание, решение задач и мышление... относятся к гипотетическим стадиям или аспектам процесса познания» (там же).

Найссер с осторожностью подходит к определению ведущей метафоры когнитивной психологии. Отмечая, что компьютерная метафора, по-видимому, уступает по своей эвристичности программной (сравнению психических процессов с машинными программами в духе Миллера, Галантера и Прибрама), он подчеркивает, что речь идет лишь о сходстве, но не об идентичности машинных программ и психических процессов. Значение обеих метафор состоит не только в доказательстве правомерности изучения внутренних психических процессов, но и в том, что они позволяют делать это без учета нейрофизиологических данных. В самом деле, если психика — это нечто вроде компьютерных программ, или «софтвера» (англ. software), а мозговые механизмы — собственно «хардвера» (англ. hardware), то очевидно одни и те же программы могут быть запущены на разных, в смысле физической реализации элементов, компьютерах (кремний, пневмоника, фотоника и т.д.). Найссер отмечает, что конечная задача когнитивной психологии состоит в демонстрации роли знания в детерминации поведения человека.

Особенно подробному анализу подвергается судьба сенсорной информации. Ее «превращения» начинаются с попадания в периферические блоки памяти: «иконическую» для зрения и «эхоическую» для слуха. Затем эта информация поступает в вербальную кратковременную память, где сохраняется с помощью процессов скрытого или явного про-говаривания. Подчеркивая конструктивный характер как низших, так и высших познавательных процессов, Найссер различает в них две фазы. Первая — фаза предвнимания — связана с относительно грубой и парал-

дельной обработкой информации. Вторая — фаза фокального внимания — имеет характер конструктивного акта, отличающегося «осознанной, внимательной, детальной и последовательной» обработкой. Только на этой второй фазе становится возможным вербальное кодирование информации, служащее предпосылкой для ее длительного сохранения в памяти и последующей реконструкции (см. 4.2.1).

Тезис об активности познавательных процессов развивается на примере психолингвистической модели «анализа через синтез». Согласно этой модели, при восприятии речи мы пытаемся построить внутреннюю репрезентацию предложения, максимально похожую на оригинал. Если слово предъявляется на фоне шума, то предвнимательный анализ первоначально может выделить лишь отдельные различительные признаки или слоги, после чего последовательно синтезируются несколько вероятных слов, пока одно из них не совпадет с информацией на входе. Это встречное моделирование — антиципация — может происходить на разных уровнях описания материала: буквы, слоги, слова, целые предложения. Результатом являются такие известные феномены, как ошибочное восприятие слов, которые отсутствовали в сказанной фразе, но хорошо подходят по контексту, пропуск ошибок в типографском тексте и, наконец, эффект превосходства слова Кеттела, то есть более быстрая и вообще более эффективная обработка слов, чем случайных последовательностей тех же самых букв (см. 3.3.3 и 7.2.2).

Значительное место в книге Найссера отводится феноменам памяти, в том числе зрительным образам, вновь возвращенным из бихевиористского изгнания. Найссер интерпретирует эти феномены по аналогии со зрительным восприятием. Последнее означает для него развернутый процесс интеграции получаемых во время отдельных фиксаций «кадров» зрительной информации, или «икон». Речь идет «о постоянно развивающейся схематической модели, к которой каждой фиксацией добавляется дополнительная информация» {там же, с. 180). Для такой развернутой во времени интеграции необходимо, очевидно, некоторое пространство — зрительная память. «Схематические зрительные объекты» могут быть синтезированы повторно. Это и есть образы представлений, которым, следовательно, свойствен такой же конструктивный характер, как и восприятию. «Существует аналогия между ролью хранящейся информации при воспроизведении и ролью стимульной информации в восприятии. В том и в другом случае информация не попадает прямо в сознание... В области психологии памяти... можно предложить модель работы палеонтолога, которую мы использовали для объяснения восприятия и внимания: по нескольким сохранившимся костям мы восстанавливаем динозавра» {там же, с. 285).

В связи с этим вариантом концепции творческого синтеза перед Найссером встают две проблемы. Первая, называемая им «проблемой исполнителя», заключается в необходимости устранения гомункулуса из объяснительных схем. Вторая проблема, возникающая в теории Найссе-

pa, это адекватность восприятия. Если восприятие, воображение, галлюцинация — наши внутренние конструкции, то как различить подлинное восприятие, представление имевших когда-то место событий и нечто впервые воображаемое? Ответ Найссера на этот вопрос довольно формален и, вообще говоря, не очень убедителен: «Индивид имеет образы представлений тогда, когда он вовлечен в выполнение некоторых из тех же самых когнитивных процессов, которые имеют место и при восприятии, но когда отсутствуют раздражители из внешнего мира, вызывающие это восприятие»9.

Книга Найссера представляла собой пример широкого, хотя и несколько эклектического синтеза различных подходов. На базе компьютерной метафоры были объединены структурализм Вундта и функционализм Бартлетта, гештальтпсихология и лингвистика Хомского. По сути дела (например, с точки зрения разделения процессов предвнима-ния и фокальной обработки, соответствующих тому, что столетием ранее называлось перцепцией и апперцепцией — см. 1.2.2), эта работа больше всего напоминала осовремененный вариант вундтовской экспериментальной психологии. Плюрализм, распространявшийся также и на методологию исследований, где соседствовали гипотетико-дедуктивный метод и самонаблюдение, несомненно, оказался одной из привлекательных черт когнитивного подхода в целом, позволившей представителям разных психологических традиций, а также специалистам в соседних с психологией областях принять это новое глобальное направление.2.2.3 Принципы символьного подхода

В течение 1970-х годов в психологии и за ее пределами, прежде всего в работах по искусственному интеллекту, сложилось относительно единое мнение о теоретических основаниях, методах и моделях когнитивных исследований. Перед тем как перейти к обсуждению более современных подходов и проблем, мы попытаемся кратко обрисовать основные черты этих представлений, которые можно было бы назвать «консенсусом 1970-х годов». С точки зрения терминологии специалистов в области теории и истории науки, речь идет о частном случае так называемой «парадигмы нормальной науки» (см. 9.1.1), то есть о совокупности явно или неявно разделявшихся тогда абсолютным большинством исследова-

![]() 9 Начиная со следующей после «Когнитивной психологии» работы «Познание и реальность» (русский перевод, 1981), Найссер связывает возникновение образов с неподтверждением наших ожиданий изменения вида объектов и окружения в процессах реальной или интериоризированной активности (см 5 3 1 и 6 3 1) Примерно так же можно интерпретировать объяснение возникновения внутреннего — психологического, или «идеального» — плана активности и в работах некоторых психологов, исследовавших процес-118 сы отногенеза, прежде всего ? Я Гальперина и Ж Пиаже

9 Начиная со следующей после «Когнитивной психологии» работы «Познание и реальность» (русский перевод, 1981), Найссер связывает возникновение образов с неподтверждением наших ожиданий изменения вида объектов и окружения в процессах реальной или интериоризированной активности (см 5 3 1 и 6 3 1) Примерно так же можно интерпретировать объяснение возникновения внутреннего — психологического, или «идеального» — плана активности и в работах некоторых психологов, исследовавших процес-118 сы отногенеза, прежде всего ? Я Гальперина и Ж Пиаже

телей теоретических и методологических допущений. С известной долей условности можно выделить четыре принципа традиционной парадигмы ранней когнитивной психологии:

Итак, самым первым принципом, отличающим этот подход от бихевиоризма и, скажем, психоанализа, было подчеркивание роли знаний и рационального мышления: люди — это автономные и рациональные существа, использующие свои знания для того, чтобы в рамках доступных ресурсов оптимизировать взаимодействие с окружением.

Второй принцип заключался в аналогии между психологическими процессами и переработкой символьной информации в универсальном вычислительном устройстве. Предполагалось, что знания могут быть описаны как комбинации символов, которые репрезентируют объекты и события, но не похожи на них. Подобно тому, как слово «стул» фонетически и графически не более похоже на слово «шкаф», чем на слово «шарф», возможное перцептивное сходство самих символов никак не связано со сходством или различием репрезентируемых ими значений. Роль образца при этом, безусловно, выполняла теория Хомского, разделявшая два уровня репрезентации — поверхностный и значительно более абстрактный глубинный. Точно так же и в традиционном когнитивном подходе подчеркивался амодальный и условный характер (глубинных) когнитивных репрезентаций, связанных со значением. Задача когнитивной психологии понималась как возможно более детальная спецификация подобных абстрактных репрезентаций и осуществляемых над ними операций.

Общим допущением было, что познавательные процессы характеризуются определенными ограничениями, которые имеют структурные и, возможно, другие (например, энергетические — см. 4.2.2) основания. С ограничениями пропускной способности связан третий принцип когнитивного подхода: из-за конечной пропускной способности переработка символьной информации должна осуществляться главным образом последовательно. Вследствие последовательного характера обработки полезным источником сведений о внутренней организации процессов познания является измерение времени реакции в различных задачах. Поскольку измерение времени реакции — ментальная хронометрия — стало одним из основных методических приемов когнитивной психологии, рассмотрим соответствующие методики несколько подробнее.

В ряде случаев речь идет о методе вычитания Дондерса (см. 1.2.1). Логика этого метода использовалась, например, американским инже-

119

I

120

нерным психологом, впоследствии специалистом по когнитивной ней-ронауке Майклом Познером. В работах, направленных на анализ стадий переработки информации в задаче абстрагирования свойств буквенно-цифрового материала, он предъявлял испытуемым пары букв, предлагая быстро оценивать совпадение/несовпадение визуальных характеристик, «имен» букв или же их принадлежности к классам согласных и гласных звуков. В результате были измерены времена, необходимые для выделения информации все более высоких уровней абстракции. Как и в работах Дондерса, основной недостаток таких исследований состоит в предположении, что новые задачи в чистом виде добавляют или отнимают некоторые стадии переработки, не меняя остальных. Общим приемом выделения стадий, свободным от этих недостатков, стал предложенный в 1969 году сотрудником Белловских лабораторий Солом Стернбергом (Sternberg, 1969) метод аддитивных факторов. Идея этого методического приема связана с использованием факторного планирования эксперимента и дисперсионного анализа (они были разработаны в 1920-х годах Рональдом Фишером, 1890—1962).

Допустим, что решение некоторой хронометрической задачи включает несколько последовательных этапов переработки информации, например, тех трех этапов, которые описал еще Дондерс: детекция стимула, его различение и выбор ответа (см. 1.2.1). Тогда в случае наиболее сложной задачи времени реакции выбора (п стимулов -» и реакций) можно было бы попытаться найти такие независимые переменные, или факторы, которые, селективно влияя на продолжительность каждого из этих этапов, не вызывают изменения времени переработки информации на других этапах. Наличие отдельных этапов выразилось бы в аддитивном влиянии этих факторов на общее время реакции выбора. Аддитивность двух факторов А и В означает, что при всех значениях одного фактора влияние другого постоянно. Формальным критерием аддитивности служит ситуация, при которой величина взаимодействия факторов (АхВ) в дисперсионном анализе не достигает уровня значимости. При графическом представлении результатов аддитивность выражается в появлении параллельных зависимостей.

Действительно, многочисленные данные демонстрируют существование переменных, которые, влияя на время решения тех или иных задач, не взаимодействуют между собой (Sternberg, 1969; 1999). Как показано на рис. 2.6А, к их числу в простейшем случае относятся оптическая зашумленность («читабельность») предъявляемых зрительно цифр и естественность соответствия стимулов и ответов: в соответствующих экспериментах испытуемый должен был либо просто называть показанную цифру, либо называть цифру, на единицу большую. Аддитивность (независимость) влияния этих двух факторов на время реакции свидетельствует о существовании, по крайней мере, двух независимых этапов в процессах решения данной задачи. Содержательно их можно было бы назвать этапами перцептивного кодирования и организации ответа. Время перцептивного кодирования избирательно зависит от читабельности

|

естеств. неестеств естеств. неестеств.

Соотношение стимулов и реакций

Рис. 2.6. Примеры аддитивного (А) и неаддитивного (Б) влияния на время реакции в задаче называния цифры (по· Sternberg, 1999).

цифр, а время организации ответа — от его естественности. С другой стороны, третий экспериментальный фактор — число альтернатив — взаимодействует в той же задаче как с читабельностью цифр, так и с естественностью ответов. Можно сделать вывод, что этот фактор влияет на продолжительность каждого из выделенных выше этапов переработки, а его полезность для тестирования процессов на одном из этих этапов ограничена.

Четвертый принцип традиционного когнитивного подхода состоял в нарочито нечетком определении связи психологических и нейрофизиологических процессов. Считалось, что хотя процессы переработки символьной информации как-то связаны с мозговым субстратом, эта зависимость не является жесткой. Скорее всего, работающий мозг .— необходимое, но не достаточное условие формирования символьных репрезентаций и психологического контроля поведения. Для представителей искусственного интеллекта, кстати, мозговой субстрат не был даже необходимым условием — предполагалась, что полноценные когнитивные репрезентации могут быть сформированы также и достаточно мощной компьютерной программой. В силу нечеткости психофизиологической связи, для многих научных и практических целей вполне достаточным представлялось формальное описание вовлеченных в переработку информации процессов, даже если их мозговой субстрат остается неизвестным. Подобное формальное описание строилось на базе формализации предложений естественного языка, то есть предполагалось, что внутренние репрезентации знания имеют в своей основе вер-бально-логический характер.

Представления об абстрактно-символьной природе внутренних репрезентаций были наиболее полно разработаны Аланом Ньюэллом. Подобные представления были необходимы, чтобы полностью использовать потенциал компьютерной метафоры и показать, что знания и следствия из них (умозаключения) могут в буквальном смысле слова вычисляться. Единицей знания при этом (см. также 5.3.1, 7.1.3 и 8.1.1) считается пропозиция — логическое суждение (утверждение), которое может быть либо истинным, либо ложным.

В логике и лингвистике существуют разные подходы к описанию пропозиций. Традиционный подход близок к описанию структуры предложения и состоит в выделении в составе пропозиции субъекта, предиката (отношения, свойства) и объекта. Этот подход, однако, проблематичен, так как субъект и объект легко могут меняться местами без изменения истинности утверждения: «Россия продала Аляску Америке» и «Аляска была продана Россией Америке». Поэтому более современным, отвечающим духу математической логики подходом является трактовка предиката как логической функции, или отношения, в которое могут подставляться различные аргументы (объекты отношения). В зависимости от характера предиката (отношения) пропозиция может допускать различное количество аргументов. Примером одноместного предиката служит выражение твердый (карандаш), двуместного — на (книга, стол), трехместного — подарить (Маша, Летя, яблоко) и т.д. В качестве аргументов таких выражений могут выступать не только существительные, имена собственные и местоимения, но и целые пропозиции, в связи с чем говорят о предикатах второго порядка. Например, предикат установления причинно-следственной связи, cause, способен рекурсивно объединять серию более элементарных пропозиций:

cause [подарить (Маша, Петя, яблоко), благодарить (Петя, Маша)].

живое существо

|

птица |

Мурка

Чижик

Рис. 2.7. Пример простейшей семантической сети.

На базе пропозициональных репрезентаций возможно выполнение вычислений, для которых используется пропозициональная логика, называемая также исчислением предикатов. Подчеркивание роли пропозиционального описания знания, таким образом, тесно связано с поставленной еще Лейбницем (см. 1.1.2) задачей автоматического вывода и моделирования умозаключений. Существует большое количество производных от пропозиций средств моделирования, наиболее известными из которых являются семантические сети. Они представляют собой пространственные структуры, включающие узлы (понятия, объекты, аргументы) и связи между ними (отношения, функции, предикаты). Пример фрагмента простейшей семантической сети показан на рис. 2.7 С помощью подобных сетей возможно моделирование процессов категоризации и простых умозаключений (см. 6.2.1 и 8.2.1). Так, если два понятия «лебедь» и «щука» объединены иерархически более высоким узлом «живое существо», то возможен перенос части свойств, приписанных данному узлу, с одного понятия на другое. Иными словами, интерпретация и репрезентация понятий в символьном подходе прямо зависят от процессов категоризации: как только понятие относится к некоторой более

123

абстрактной категории, оно наследует семантические признаки этой категории10.

В конце 1970-х годов появились и другие средства моделирования когнитивных процессов, прежде всего так называемые системы продукций или марковские алгоритмы, названные так в честь русского математика A.A. Маркова (1858—1922). Одним из примеров могут служить правила перезаписи порождающей грамматики Н. Хомского (см. 1.3.3). Они представляют собой колонку пар (продукций) типа «условие» —» «действие»: если на вход системы продукций попадает одно из «условий», то оно автоматически приводит к соответствующему «действию». Продукции можно представить как определенные правила, например: «Если идет дождь, то нужно взять с собой зонт», хотя речь может идти и о средствах моделирования простых связок: «стимул» —» «реакция» Управление начинается сверху колонки и последовательно спускается вниз до нахождения первого подходящего условия. После осуществления операций — «действий» — управление вновь начинается с верхней строчки В отличие от обычных машинных программ системы продукции практически не обладают структурой, в них, в частности, отсутствует обычный для многих языков программирования оператор перехода к другим участкам программы (оператор «go to»). Простота систем продукций привела к тому, что они стали широко использоваться при когнитивном моделировании (см. 6 4.1 и 9 2.1). В связи с упоминанием «действий» много надежд было связано и с возможным использованием систем продукции для дополнения моделей когнитивных функций (прежде всего памяти и мышления) моделями сенсомоторных процессов.

Оценивая перспективы когнитивной психологии, один из ее представителей писал в эти годы: «Развитие этого направления науки обещает оказать на нашу философию влияние, которое будет, по крайней мере, столь же существенным, как влияние дарвинизма» (Broadbent, 1961, р. 11). Этот энтузиазм разделялся большинством психологов. Пожалуй, единственным крупным автором в американской психологии, который позволил себе публично выразить сомнение, был специалист по восприятию Джеймс Джером Гибсон: «Многие психологи, видимо, думают, что сейчас нужно только собрать воедино все наши научные достижения. Их самоуверенность удивляет меня. Ведь эти достижения очень сомнительны, а сама научная психология, по-моему, плохо обоснована. В любой момент все может опрокинуться, как тележка с яблоками» (Gibson, 1967, р. 142). Может показаться удивительным, но именно его взгляды оказали особенно сильное влияние на более поздние работы одного из основателей когнитивной психологии Найссера, а также на многие ведущиеся сегодня дискуссии (см. 9.3.2).

![]() 124

124

10 Следует иметь в виду, что речь идет о процессах индуктивного вывода, которые в случае реальных семантических категорий всегда могут сопровождаться ошибками Например, свойство (предикат) ЛЕТАЕТ, приписывемое концептуальному узлу ПТИЦА, не может быть распространено на некоторые примеры этой категории, такие как СТРАУС и ПИНГВИН (см 6 2 1)

Действительно, традиционный когнитивный подход оставлял нерешенными много серьезных проблем. Так, не вполне понятной оказалась проблема первичного определения значений — «проблема заземления символов» (symbolgroundingproblem). На поздних этапах изучения языка понятия могут задаваться посредством определения и ссылок на другие символы (см. 6.1.1). Но можно ли выучить китайский язык с самого начала, имея в распоряжении лишь китайско-китайский толковый словарь, к тому же без картинок (см. 9.2.2)? Очевидно, первичное «заземление» понятий возможно в контексте непосредственного восприятия и предметных действий, однако именно они были исключены из рассмотрения. Акцент на вербально-логическом, амодальном описании знаний оставлял открытым также вопрос о природе образных явлений (их изучение привлекло поэтому внимание многих талантливых исследователей — см. 5.3.1 и 6.3.1). Далее, наши действия и восприятия явно непрерывны, поэтому их трудно описывать дискретными логическими функциями. Программы символьной обработки, например, так и не позволили смоделировать элементарный феномен восприятия — разделение видимого поля на фигуру и фон (см. 1.3.1). Вместе с тем, они оказались достаточно успешны при моделировании решения логических задач и даже игры в шахматы.

Из возникших в тот период дискуссий и новых данных к концу 1980-х годов постепенно возникли подходы, поставившие под сомнение универсальную применимость символьного подхода. В центре внимания оказались процессы параллельной обработки и «субсимвольной репрезентации» знания, в частности, процессы, лежащие в основе нашего непосредственного взаимодействия с окружением — локомоций, восприятия и действия с предметами. Новые нейрофизиологические методы, такие как трехмерное картирование активности мозга (см. 2.4.2), были быстро включены в арсенал средств психологических исследований. Радикально изменился и сам характер когнитивных теорий, в фокусе которых, наряду с нейропсихологическими механизмами, все чаще оказываются проблемы развития и коммуникативного взаимодействия. Можно сказать, что сегодня мы имеем дело с другой психологией и другой когнитивной наукой. Они стали в большей степени соответствовать представлениям об объединяющей различные научные дисциплины и субдисциплины единой романтической науке (см. 1.4.3 и 9.4.1), чем это могли представить себе создатели первых метафор данного направления.

125

Вплоть до начала 1980-х годов единственной претеоретической метафорой когнитивной психологии оставалась компьютерная метафора, с характерной для нее аналогией между психологическими процессами и переработкой информации в универсальном вычислительном устройстве. Такие компьютеры, во-первых, имеют однопроцессорную архитектуру. Во-вторых, для них характерно разделение пассивных данных и активных операций над ними, причем последние объединены в более или менее сложные, заранее написанные программы. В вычислительной технике и информатике эти вычислительные устройства иногда называются «фон-неймановскими», по имени венгеро-американского математика и логика Джона фон Неймана, предложившего в 1947 году, на пороге масштабной компьютерной революции, соответствующую схему физического воплощения машины Тьюринга (см. 2.1.1)".